Поисковая оптимизация включает в себя как улучшение внутреннего содержания сайта (качества и количества информации, совершенствования внутренних технических аспектов реализации сайта, улучшения его визуальной привлекательности для потенциальных пользователей), так и работу над внешними факторами (ссылки, ведущие на сайт, цитируемость сайта на других ресурсах и прочее).

Согласно исследованиям, процент посетителей сайтов можно отобразить схемой, представленной на рисунке

Следовательно, наиважнейшим источником посетителей для сайта являются поисковые системы.

В последнее время всё чаще звучит определение поисковой оптимизации как ветви Интернет-маркетинга. Поисковый маркетинг, как следующий шаг в развитии SEO являет собой ту же поисковую оптимизацию. Данная оптимизация сайта включает в себя не только техническую работу над страницами ресурса, но и анализ рынка поисковых услуг с учётом текущих потребностей в спросе и предложении.

Процесс оптимизации сайта для поисковых систем заключается в определённой работе над контентом сайта и его структурой, а также над внутренними и внешними факторами, позволяющими поисковым машинам, основываясь на текущей версии их алгоритма, присваивать сайту некоторое место в поисковой выдаче среди прочих известных ему страниц.

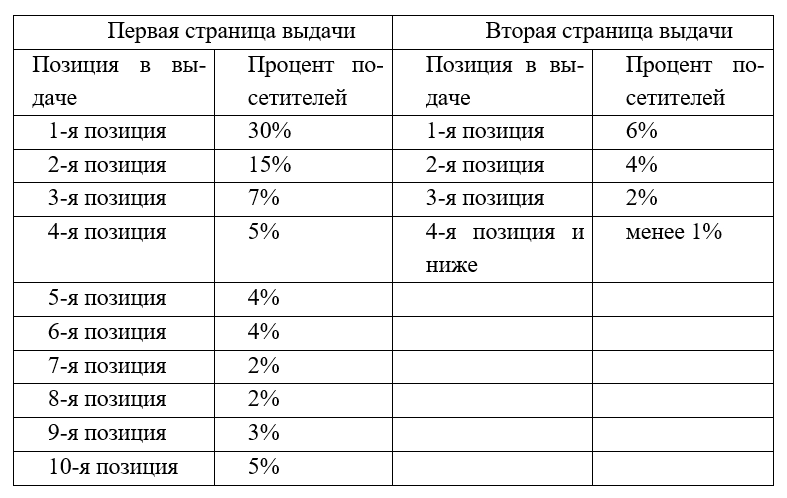

Согласно исследованию компании Google имеется следующее распределение посетителей сайтов в поисковой выдаче в зависимости от позиции, показанное в таблице

Как видно из таблицы, наиболее успешными с точки зрения посетителей являются первые три строчки выдачи. Как правило, перед началом оптимизации ставится задача, на какое место в поисковой выдаче ожидается про-двинуть сайт. Учитывая поведенческие факторы, такие, как потеря интереса у пользователей по мере удаления от вершины поисковой выдачи, целью оптимизации является непосредственно первая страница поисковика и три строчки второй страницы.

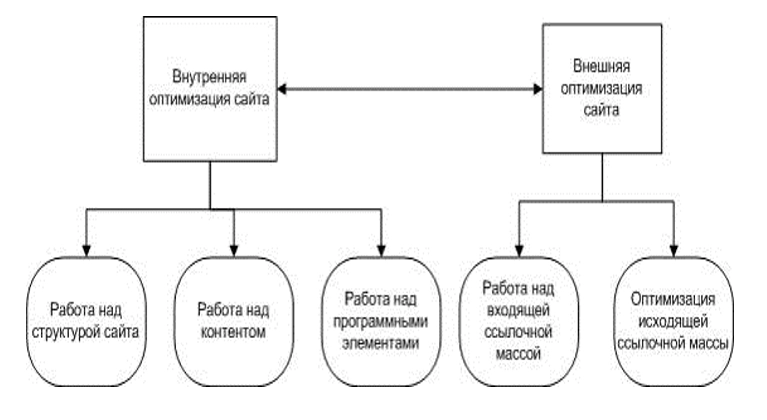

В целом, поисковая оптимизация делится на два вида: внешнюю и внутреннюю оптимизацию

Внутренняя поисковая оптимизация - это набор действий и методов, направленных на улучшение внутреннего содержания и структуры сайта. К внутренней оптимизации непосредственно относится:

- создание семантического ядра сайта, то есть подбор тех ключевых слов, по которым сайт будет отображаться в результатах поиска;

- редактирование текстов, исправление орфографических либо логических ошибок;

- техническая работа над структурой сайта: создание карты сайта, присваивание страницам легко запоминающихся и понятных адресов, задание инструкций для поисковых роботов и прочие методы, призванные упростить работу с сайтом как пользователям, так и поисковым машинам;

- работа над дизайном сайта и повышение визуальной привлекательности ресурса;

- устранение технических ошибок, замедляющих или вовсе компрометирующих работу сайта: начиная от несуществующих ссылок и дублей страниц, заканчивая грубыми семантическими и логическими ошибками в коде страниц, действующих на них скриптов, сетевых приложений.

К внешней оптимизации относится такие методы, как наращивание ссылочной массы на сайт и анализ работы, произведённой другими оптимизаторами. Наращивание ссылочной массы представляет собой размещение ссылок на продвигаемый сайт. Первоначально поисковые системы ориентировались в основном на то, сколько ссылок имеет сайт и согласно этому присваивали им место в поисковой выдаче. Сейчас же поисковики научились более тщательно анализировать содержание сайта, что, несомненно, благоприятно отразилось на качестве Интернет-ресурсов.

Внешняя оптимизация влияет на такие показатели, как ИКС (Индекс Качества Сайта), ВИЦ (Взвешенный Индекс Цитирования) и PR (англ. Page Rank) - «ранг страницы».

ИКС - это показатель того, насколько полезен сайт для пользователей с точки зрения «Яндекс».

ВИЦ - совокупность параметров, учитывающая популярность сайтов, ссылающихся на определённый ресурс.

PR - аналогичный метод компании «Google», определяющий количество и популярность страниц, ссылающихся на тот или иной ресурс. Каждой странице либо объекту в сети присваивается некоторое начальное числовое значение, которое изменяется в зависимости от количества ссылок на него. Суть метода в том, что все объекты, связанные гиперссылками представляются в виде графа и чем больше ссылаются на определённую страницу в сети, тем «важнее» она выглядит для поисковой системы.

Существует определённое деление на типы поисковой оптимизации в зависимости от применяемых методов, так называемые: «белая», «серая» и «чёрная» оптимизация.

Под «белой» оптимизацией подразумевают некий комплекс мер, направленных на повышение позиции сайта в поисковой выдаче, в результате которых не нарушаются какие-либо правила, установленные поисковыми сервиса-ми для индексируемых сайтов.

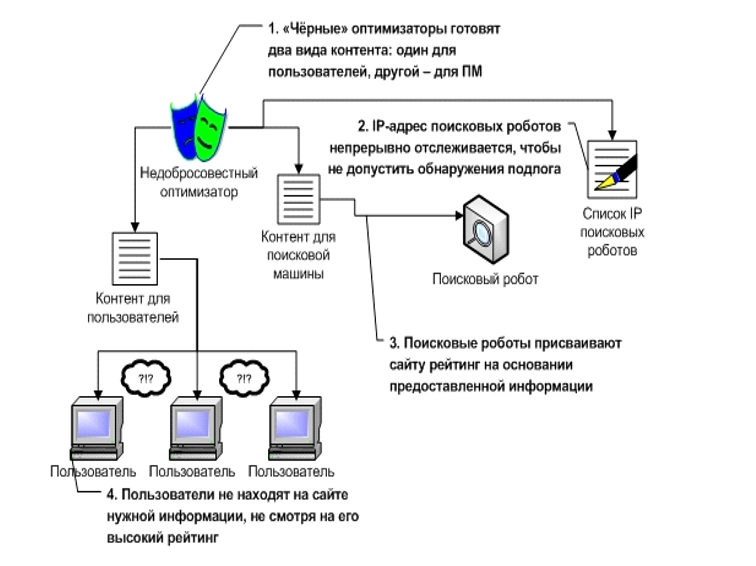

«Чёрная» оптимизация же наоборот, ставит своей целью именно обман поисковой системы, что зачастую влечёт за собой соответствующие последствия со стороны поисковой машины. Сайт, уличённый в жульничестве, может быть понижен в общей поисковой выдаче, а то и вовсе исключён из него, не говоря уже о морально-этических аспектах такого рода оптимизации. Пример «черной» оптимизации представлен на рисунке

Что касается «серой» оптимизации, то она не влечёт серьёзных санкций со стороны поисковиков, так как не нарушает напрямую тех правил, которые устанавливают поисковые системы для сайтов при индексации. Данный вид продвижения требует от специалиста хорошего уровня навыков и опыта, а также знаний внутреннего устройства и принципов работы поисковой машины.

В настоящее время поисковые сервисы занимают ведущее положение в распределении трафика пользователей сети Интернет. Поисковые системы выполняют важнейшую функцию: они занимаются распределением внимания пользователей между сайтами, занесёнными в их базу данных.

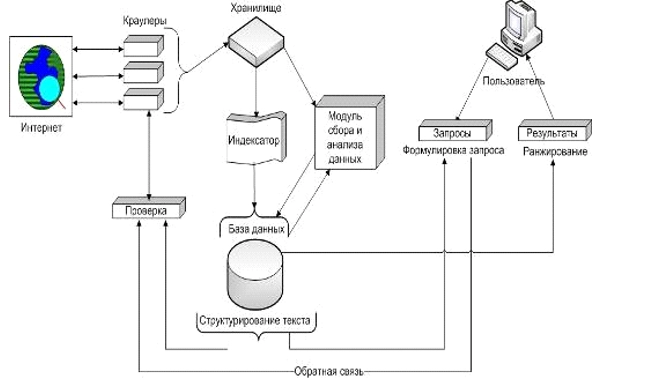

Поисковая система в целом состоит из пяти основных программных компонентов:

- «Паук» (англ. Spider) - модуль, скачивающий страницы из сети Интернет. Он воспринимает информацию страницы в режиме исходного кода и именно в таком виде сохраняет её в базе данных;

- «Краулер» (англ. Crawler), что в переводе с английского означает «ползающий». Этот модуль ответственен за просматривание всех ссылок, имеющихся на странице и занесение их в базу данных. На основе этой информации он формирует путь, по которому будет двигаться «Паук»;

- Индексатор (англ. Indexer) - данный модуль разделяет страницу на составные элементы, такие как: заголовки, подзаголовки, основной текст, жирный и курсивный шрифт, а также прочие информативные элементы. Разделив, таким образом, страницу, он проводит её анализ в зависимости от текущего алгоритма поисковой системы;

- база данных (англ. Database) - фактическое место хранения всей накопленной информации о веб-сайтах, собранной как «краулером», так и «пауком», а также результатов работы индексатора и прочей информации, необходимой для работы системы;

- система выдачи результатов (англ. Search engine results engine) - это программный модуль, просматривающий базу данных и выбирающий наиболее релевантные запросу пользователя страницы.

Функционирование поисковой машины отображено на рисунке

Вначале «краулер» просматривает известные ему ресурсы в поиске новых ссылок. Он совершает регулярные проходы всех известных ему ссылок разыскивая при этом новые. Находя их, он выполняет по ним переход. Стоит отметить, что на каждое доменное имя «краулером» выделяется определённое время для поиска ссылок. После истечения этого времени, «краулер» отправляется дальше по сети, возвращаясь в следующем проходе.

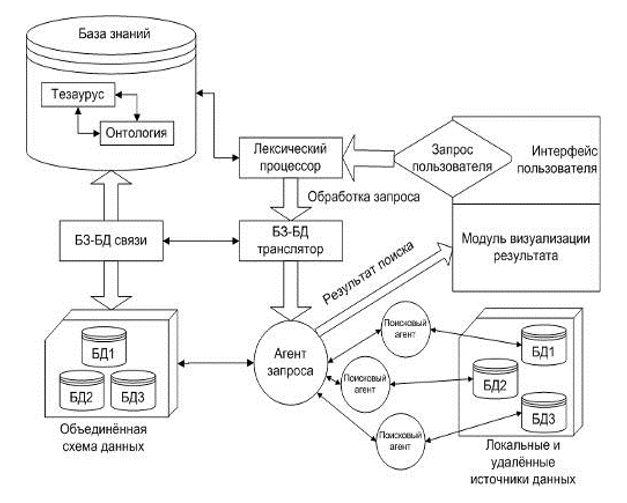

>Далее начинает свою работу модуль, называемый «пауком». Он пользуется найденными «краулером» ссылками, как картой, и скачивает содержимое страниц в режиме исходного кода и передаёт её для обработки индексатору. Этот модуль разделяет текст страницы на составные элементы: заголовки, жирный и подчёркнутый текст, выделение абзацев и прочее. Это делается для удобства поиска по проиндексированным документам. Обработанные страницы поступают в базу данных поисковой системы. Следует отметить, что на данный момент поисковые роботы проводят индексацию мультимедийных данных (таких, как аудио- и видеофайлы, флеш-анимация и прочие крайне не-эффективно. Этот факт оказывает существенное влияние на выбор методов поисковой оптимизации сайта. Ввиду этого многие SEO-специалисты рекомендуют закрывать программный код внутри страницы специальными HTML-тегами для предотвращения индексации. На рисунке отображена схема извлечения данных из поисковой машины.

Неверно считать, будто поисковая машина производит поиск заданной пользователем фразы по всей сети Интернет. Скачанные в режиме исходного кода страницы хранятся в базе данных поисковой системы, а затем извлекаются, когда пользователь вводит свой запрос в поисковую строку. Работая с таким огромным объёмом информации, необходимо применять особые алгоритмы, сортирующие результаты поиска.

Несмотря на то, что поисковые системы стараются как можно чаще обновлять свои базы данных, существует множество сайтов, которые никогда не попадут в поисковую выдачу:

- ресурсы, доступ к которым защищён паролем;

- не связанные с другими сайтами ресурсы;

- сайты, представляющие из себя так называемый «информационный шум»: брошенные, незавершённые сайты.